迅睿CMS日志剖析:那些有效爬取途径的“奥密”

你晓得吗 迅睿CMS的日志文件里藏着非常多“宝藏” 尤其是那些有效爬取途径 它们就像一个个小线索 能帮你发现网站的咨询题 但咨询题是 怎样从一堆日志里找到这些“宝藏”呢 不急 我们渐渐聊

日志文件 从哪儿开端看

首先 你得晓得日志文件在哪儿 迅睿CMS的日志通常放在 /runtime/log/ 目录下 文件名普通是按日期命名的 好比 20231001.log 翻开一看 密密层层的文字 不慌 我们渐渐来

日志里记载了每次拜候的详细信息 包含工夫 IP地址 拜候途径 形态码等等 你要找的是那些形态码是404的拜候 这些确实是有效爬取途径 但 光是找到404还不敷 你得剖析这些途径是怎样来的

404 纷歧定是好事

404错误 非常多人觉得是好事 事实上否则 它更像是一个信号 通知你 这个地方有咨询题 能够是链接生效了 也能够是爬虫在乱爬 你得搞清楚 这些404是怎样发生的

好比 有些404是由于你删除了某个页面 但内部链接还在 或许 你改了URL构造 但没做好重定向 这些都会招致404 还有一种状况 确实是爬虫在乱爬 它们会尝试各种途径 看看能不克不及找到点什么 这些有效爬取途径 确实是你要关注的

爬虫的“猎奇心”

爬虫就像个猎奇宝宝 它们会尝试各种途径 看看能不克不及找到点什么 有些途径 你基本没想到 但它们确实是会去试 好比 你有个页面是 /about 它们能够会尝试 /about1 /about2 甚至 /about/123 这些途径 显然是不存在的 但它们确实是会去试

这些有效爬取途径 尽管可不能对用户形成妨碍 但会糜费办事器资源 尤其是当爬虫频繁拜候时 办事器压力会非常大 因此 你得想方法 增加这些有效爬取

怎样增加有效爬取

首先 你能够经过robots.txt文件 通知爬虫哪些途径不要去爬 好比 你能够制止爬虫拜候 /admin /config 这些敏感途径 但 robots.txt 只是个建议 爬虫纷歧定会恪守 因此 你还得想不的方法

其次 你能够经过日志剖析 找出那些频繁拜候有效途径的IP 然后 在办事器上设置规则 屏蔽这些IP 或许 限制它们的拜候频率 如此 能够增加办事器的压力

日志剖析工具 不太依赖

市面上有非常多日志剖析工具 它们能帮你疾速找到有效爬取途径 但 不太依赖这些工具 由于它们能够会疏忽一些细节 好比 有些工具只会统计404的数量 但可不能通知你 这些404是怎样发生的

因此 你得本身入手 剖析日志 看看这些有效途径是怎样来的 是内部链接的咨询题 依然爬虫在乱爬 只要搞清楚缘由 能力有的放矢

有效途径 也能够是时机

有时分 有效途径也能给你带来时机 好比 你发现某个途径被频繁拜候 但它并不存在 这时分 你能够思索 是不是应该创立那个页面 也许 用户确实需求那个内容

好比 你发现非常多人拜候 /product/123 但那个产品曾经下架了 这时分 你能够思索 是不是应该重新上架那个产品 或许 创立一个相似的页面 满足用户的需求

日志剖析 不太死板

日志剖析 不太死板 你得灵敏一点 有时分 一些看似有关的信息 能够正是你需求的 好比 你发现某个IP频繁拜候有效途径 但它的拜候工夫非常有规律 这时分 你能够思索 是不是有人在歹意爬取你的网站

或许 你发现某个途径的404数量忽然添加 这时分 你能够思索 是不是比来做了什么改动 招致了那个咨询题的呈现 日志剖析 不只仅是找咨询题 更是找时机

最初 不忘了按期清算日志

日志文件会越来越大 按期清算是必需的 但 不一删了之 你能够把日志文件备份到其他中央 或许 紧缩存档 如此 当前需求的时分 还能找回来

迅睿CMS的日志文件 是个宝藏 你得好好应用 不让它白白糜费了 有效爬取途径 尽管看起来是个咨询题 但处置好了 也能酿成时机 关键看你怎样用

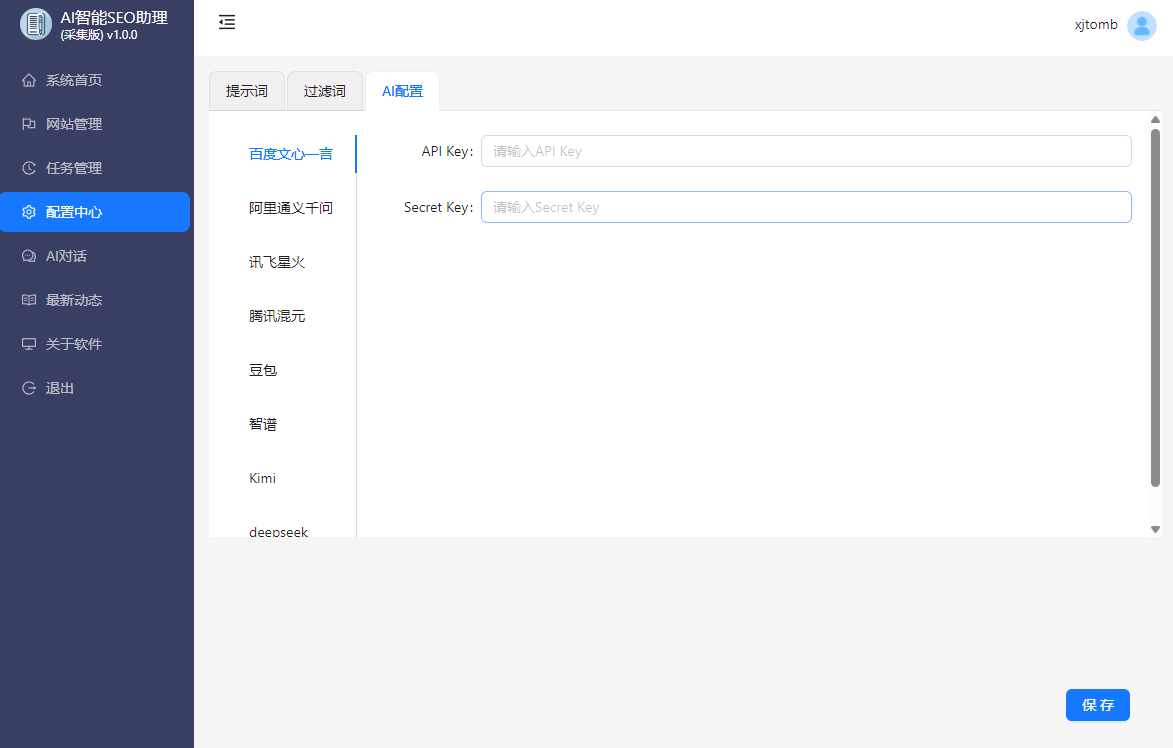

AISEO助理,AI批量生成文章,SEO文章生成工具,SEO原创文章生成,AI媒体助理,AI自动回复,AI自动评论,媒体账号管理,自媒体一键分发