站群蜘蛛池的IP隔离究竟在防什么?

搞过SEO的老铁都晓得,搜索引擎最烦的确实是"作弊嫌疑"。你想想啊,要是同一个IP底下忽然冒出几十个网站,内容还都差不多,这不摆明了通知人家"我在玩站群"嘛。IP隔离讲白了确实是给每个站点配个独立身份证,让蜘蛛觉得这些网站八棍子撂不着关系。

有个做当地办事的客户跟我吐槽,他之前用共享主机建了十几个都市分站,后果全被当成了渣滓站。后来换了独立IP,流量才渐渐回来。这事儿特不典型——你以为省了主机钞票,事实上赔的是搜索权重,亏大发了。

真实案例里的血泪经验

去年见过最惨的案例,有个团队用云办事器开了200个C段IP,后果全分配在同一个机房。尽管IP分歧吧,但whois信息、AS号全都一样。搜索引擎如今精得非常,这种"伪装不看法"的操作基本糊弄不外去,最初全站被K,三个月的心血直截了当打水漂。

这个地方有个失常识的点:不是买了独立IP就万事大吉。你得看IP段的历史记载,要是前主人做过黑帽SEO,那那个IP能够自带"debuff"。我普通会建议客户多花点钞票买洁净IP,贵是贵点,但总比前期洗白来得划算对吧?

技术完成上的三个坑

第一个坑是DNS解剖判。非常多人觉得用分歧域名就平安了,事实上NS记载裸露在同一个办事商照样穿帮。有个取巧的方法是把DNS分散到Cloudflare、DNSPod这些分歧平台,尽管费事点,但效果的确好。

第二个坑在办事器指纹。如今连TLS握手都能检测出办事器类型,更不讲呼应头里的Server字段了。见过有人给200个站点配了分歧IP,后果全用的浮屠默许配置,X-Powered-By清一色写着PHP7.2——这不等于举着牌子讲"我们是团伙作案"吗?

第三个最要命的是行为形式。你一切站点同一工夫更新,用的依然相反爬虫工具采集内容,就算IP隔离得再好也白费。建议把更新频率打散,最坏人工干涉下内容构造,不整得跟流水线产品似的。

本钱与效果的均衡术

讲假话,完全隔离的代价非常高。AWS的弹性IP要钞票,公用主机要钞票,分散注册信息更要钞票。关于小团队来讲,能够思索折中方案:中心站用独立资源,边沿站分组共享。好比10个站一组,每组配独立云主机,如此本钱能降六七成。

有个做跨境电商的客户更绝,他们用住宅代理做蜘蛛池。尽管速度慢点吧,但IP基本上真实家庭宽带,反而比机房IP更"洁净"。这种野路子纷歧定合适一切人,但思绪值得自创——有时分最贵的方案纷歧定最无效。

如今开端该怎样操作?

先不急着买办事器,建议拿张纸画个矩阵图。横轴写站点重要性,纵轴列隔离要素:IP段、DNS、主机地位、注册信息...重要站点全部打勾,主要站点选关键项。如此预算分配就明晰多了,可不能呈现"钞票花完了才发现漏了whois掩护"的为难。

实践操作时记得做测试啊!用相似IP2Location的工具查查,确保各站点的数字脚印没有分明关联。有次我们发现客户站点的SSL证书全是一个邮箱请求的,这种细节确实非常容易被疏忽。

最初提示下,IP隔离只是根底操作。内容质量、外链建立这些根本功不到位,再好的技术架构也是白费。见过太多人本末颠倒,在技术上钻牛角尖,反而忘了SEO最实质的东西——给用户提供真实价值。你讲是不是那个理儿?

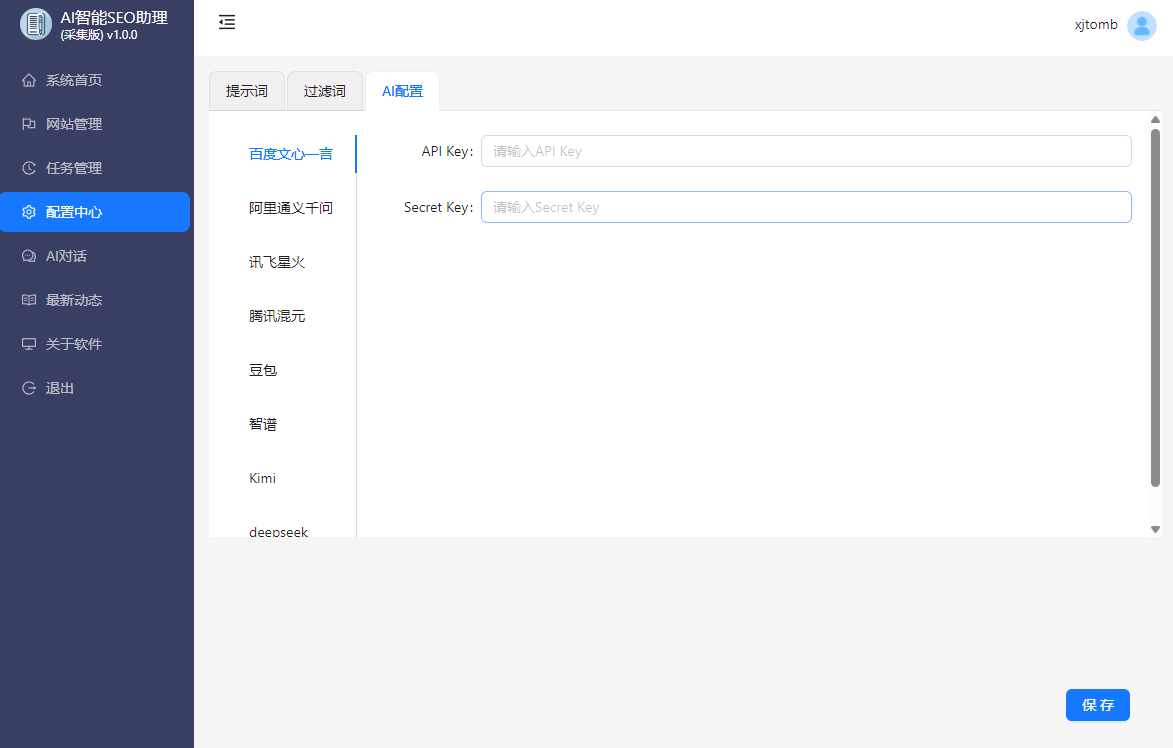

AISEO助理,AI批量生成文章,SEO文章生成工具,SEO原创文章生成,AI媒体助理,AI自动回复,AI自动评论,媒体账号管理,自媒体一键分发