外链监控这事儿,真没你想的那么玄乎

做SEO的伴侣应该都明白啊,竞争对手的外链数据几乎确实是金矿。但非常多人一听到“爬虫”“监控”就头大,总觉得得会写代码能力玩转。事实上呢,用Python搞外链监控真没那么复杂,关键是要晓得从哪儿下手。就像你买菜不消本身种地,监控外链也不消从头造轮子,现成的工具和库多得是,我们要做的确实是把它们串起来。

第一步:先搞清楚你要啥

非常多人一下去就急着写代码,后果抓了一堆没用的数据。好比你发现对手比来在某个论坛发了非常多外链,但阿谁论坛权重低得不幸,这种数据抓了也是白抓。你得先想明白:究竟哪些外链值得监控?是行业威望网站,依然流量大的门户?是忽然暴跌的新渠道,依然临时不乱的老同伴?把这些搞清楚了,前面的事儿就复杂多了。

有个取巧的方法——直截了当看对手的Ahrefs或SEMrush数据(假如你有账号的话)。重点关注那些DR(域名权重)高、流量大的外链,记下它们的特征。好比是不是都带特定锚文本?公布在什么类型的页面上?有了这些信息,你的爬虫能力精准打击,否则确实是在海里捞针啊。

第二步:工具选对,事半功倍

Python里好用的库太多了,但不贪多嚼不烂。Requests和BeautifulSoup这对黄金组合就够用了,要是遇到反爬凶猛的网站,再加个Selenium。千万不一下去就搞什么散布式爬虫,那是给本身找罪受。就像你明明只想煎个鸡蛋,非要把整个厨房装修一遍,何必呢?

这个地方有个小技巧:先用阅读器开发者工具看看目的网站的恳求构造。非常多网站的数据接口直截了当就裸露在那儿,基本不消解剖判HTML。好比你发现对手的外链数据是经过某个API前往的JSON,那直截了当requests.get()那个接口不就完事了?比吭哧吭哧解剖判DOM轻松多了。

第三步:存数据也有考究

抓到的数据往哪儿放?非常多人习气性建个MySQL表,事实上关于外链监控这种轻度需求,CSV文件能够更香。究竟你又不是要搞什么复杂剖析,无非确实是看看对手比来在哪儿发链接了嘛。要是真想初级点,丢到MongoDB里也行,文档型数据库对这种非构造化数据特不敌对。

重点是要设计好字段!除了惯例的URL、锚文本、公布工夫,建议再加个“权重评分”字段。你能够本身定义一套复杂规则,好比:威望网站的外链打5分,一般博客打3分,论坛签名档打1分。如此前期剖析的时分,一眼就能看出哪些外链值得重点关注,多省事啊。

不忘了按时义务那个神器

监控监控,关键在“继续”两个字。总不克不及每次基本上手动运转脚本吧?这时分就得祭出按时义务大法了。Windows用户能够用义务方案顺序,Linux用户直截了当crontab奔忙起。设定每天清晨自动跑一遍脚本,睡醒就能看到新颖出炉的外链申报,美滋滋。

不外要留意操纵频率啊,不把人家网站爬挂了。加个随机延时是根本礼仪,最好再假装下User-Agent。有些同窗能够觉得:“我这小爬虫不至于被发现吧?”但你想啊,竞争对手讲不定也在监控谁在爬他呢,小心驶得万年船嘛。

数据剖析才是重头戏

数据抓回来不是起点,看出门道才是关键。建议每周把数据拉出来遛遛,重点看三个变更:外链数量渐变(忽然增多或增加)、外链来源变更(新呈现的高权重网站)、锚文天职布(是不是忽然集中用某个关键词)。这些异常点往往藏着对手的SEO战略调整。

举个例子,要是发现对手忽然在某批教育类网站少量猎取外链,而你们公司正计划开辟教育市场——这不确实是现成的外链建立名单吗?这种洞察可比闷头做原创内容高效多了。记住啊,监控不是为了模拟,是为了找到弯道超车的时机。

最初讲点大假话

外链监控讲究竟只是个工具,不指望靠那个就能碾压对手。真正重要的是:你从数据里看出了什么?能不克不及疾速举动?有些人整天搜集数据,剖析申报写得漂标致亮,后果执行起来拖迁延拉。这就跟健身房里那些天天晒自拍却从不举铁的人一样,数据再美观也没用啊。

对了,提示一句:不光盯着竞争对手看,也抽空看看本身的外链情况。有时分最风险的朋友不是不人,而是本身网站上那些莫明其妙的有毒外链。工具用好了是利器,用欠好反而容易奔忙火入魔,你讲是不是那个理?

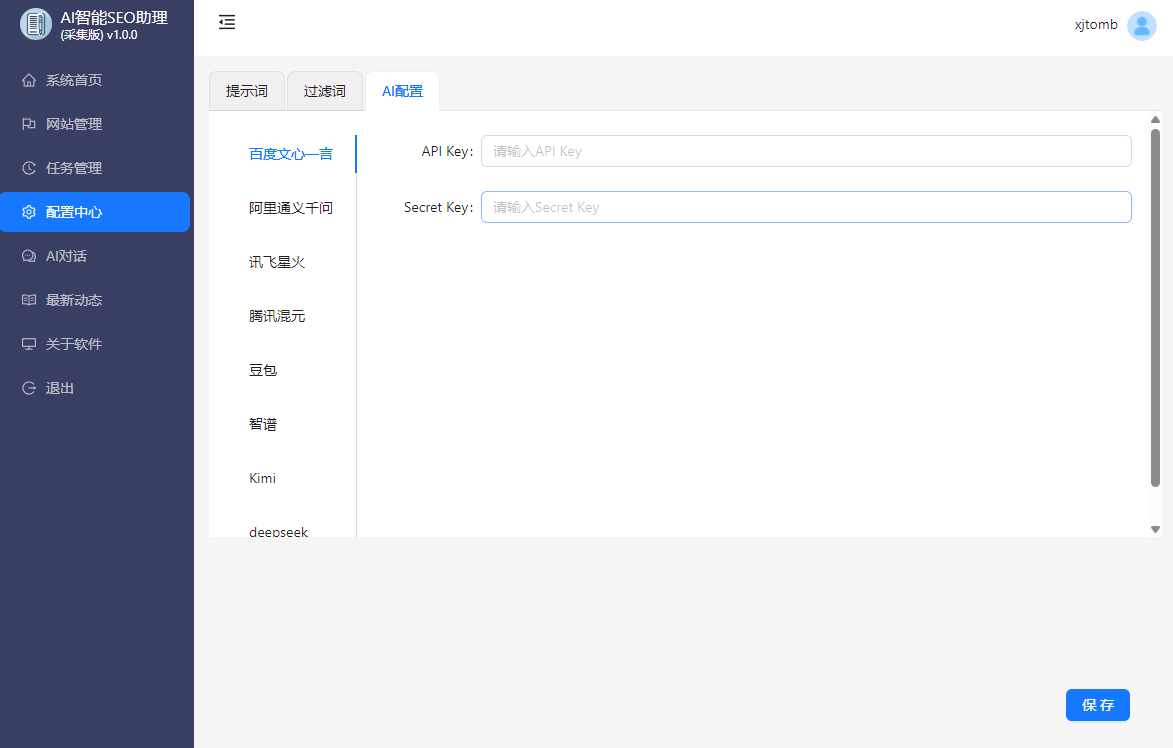

AISEO助理,AI批量生成文章,SEO文章生成工具,SEO原创文章生成,AI媒体助理,AI自动回复,AI自动评论,媒体账号管理,自媒体一键分发