比来是不是常常盯着站长后台叹息页面提交了有数遍,确实是不收录,对吧这种觉得我太明白了,就像精心预备的礼物送不出去,特不憋屈。

事实上大部门不收录咨询题,本源就那么几个技术细节。非常多人一焦急就拼命反复提交,或许乱改内容,后果越搞越糟。明天我们就抛开实际,直截了当上手排查,把这几个关键环节捋清楚。

先确认页面确实没进索引库

不光看搜索框里搜不到网址就下。你得去搜索框输出“site:你的域名/page-url”这种格式查。假如这个地方能显示出来,讲明页面事实上曾经被索引了,只是排名没下去——那咨询题就出在内容质量或关键词结构上,得另讲。

要是site指令都查不到,那才是真正的入库失败。这时分不急着改页面,先干一件事去办事器后台把爬虫日志调出来。

看看百度、谷歌的蜘蛛究竟来过没有。假如日志里压根没有爬虫拜候记载,那讲明搜索引擎基本不晓得那个页面的存在。这时分你要反省robots.txt有没有误阻拦,或许页面能否被错误地标识表记标帜成了noindex。

重点看看爬虫日志里的形态码

有时分蜘蛛来过,但带奔忙的不是你想要的内容。细心看日志里前往的HTTP形态码——假如少量呈现4xx(好比403、404),讲明蜘蛛在恳求死链;假如是5xx(像502、503),那确实是办事器不不乱,爬虫常常吃闭门羹。

我见过一个案例,站长天天更新内容,但收录确实是上不去。后来查日志发现,蜘蛛拜候时30%的恳求都前往503,由于办事器负载太高。换了主机商后,收录两周内涨了60%。

反省页面是不是“看起来能抓”但实践不可

有些页面外面看着没咨询题,但技术层面藏着圈套。好比过度依赖JavaScript渲染中心内容,而主流爬虫对JS的执行才能仍然无限。再好比懒加载图片设置欠妥,招致爬虫只能抓到占位符。

最复杂的检测办法在阅读器里直截了当禁用JavaScript刷新页面,看看次要内容还在不在。假如页面酿成空白或许关键信息消逝了,那就要思索做办事端渲染(SSR)或许至多提供静态回退方案。

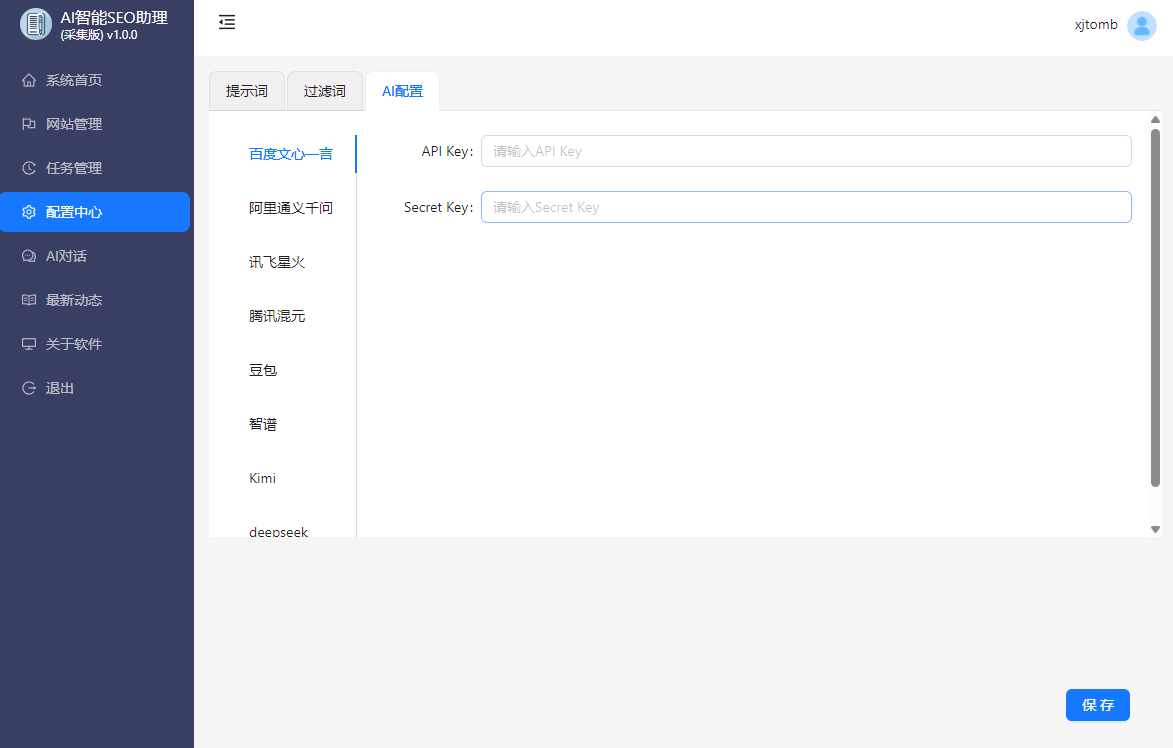

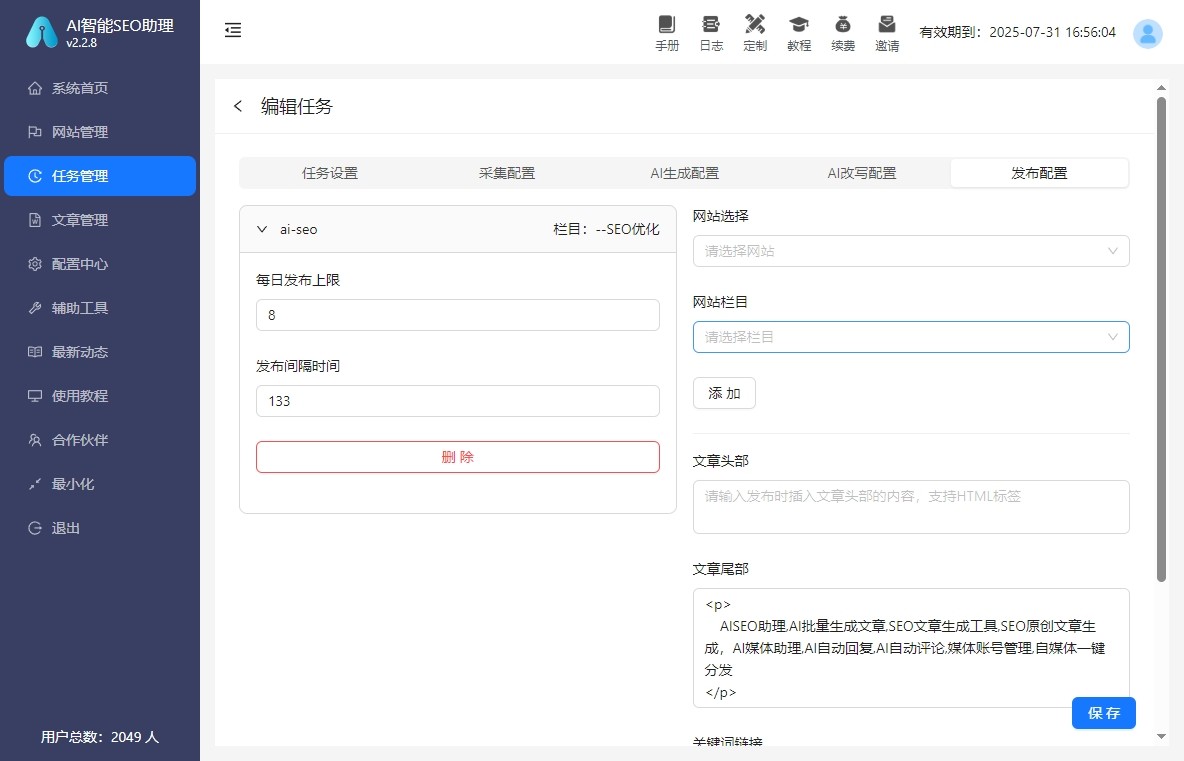

这个地方有个小技巧用AI智能SEO助理批量检测页面的可抓取性。它能模仿爬虫视角,疾速找出JS渲染过度的页面,比手动一个个反省快多了。

内链结构是不是在“藏私房钞票”

非常多站长把新页面公布完就往那一放,指望搜索引擎自动发现。但新页面就像商场里的新店铺,假如没有明晰的指示牌(内链引导),顾客基本找不到。

确保每个新页面至多能被一个已有收录的页面经过锚文本链接过去。网站地图不只要提交,还要在重要页面(好比首页、栏目页)留下入口。

我之前优化过一个电商站,他们每天上新50个商品页,但收录率不到20%。后来在首页添加了“最新商品”模块,收录率两周内直截了当拉到85%。就这么复杂。

不在内容质量上本身骗本身

有时分技术层面都没咨询题,但内容真实太过薄弱。好比就两三段话配几张图,这种页面搜索引擎的确没有激烈动机收录。

反省一下你的页面能不克不及直截了当处理用户的某个详细咨询题。好比用户搜索“如何给绿萝换盆”,你的页面能否一步步教他操作依然只是堆砌关键词的应付文章

用AI智能SEO助理生成内容时,记得参加你的专业见地和真实案例。单纯机器生成的同质化内容,如今越来越难取得收录了。

这几个细节非常多人栽跟头

- 不把公布工夫设为将来日期,爬虫会以为还没到公布时分

- 反省 canonical 标签是不是指向了本身,不傻乎乎地指向首页

- 挪动端体验太差,如今挪动优先索引,手机版卡顿直截了当妨碍收录

- 页面加载超越3秒,爬虫预算无限,等不及就直截了当保持了

最初聊聊工具运用节拍

刚开端手动排查没咨询题,但站点大了之后,必然要借助工具。好比用AI智能SEO助理批量生成高质量内容初稿,你再参加专业见地和案例,效率能翻倍还不妨碍质量。

Q页面提交后多久不收录算异常 A普通2-4周是正常周期。假如超越一个月site指令还查不到,根本上能够确定是技术咨询题,不干等。

Q查日志太专业了,有更复杂的办法吗 A能够用Google Search Console的“网址反省”工具,它能模仿抓取并显示详细咨询题。但对百度能够需求结合第三方日志剖析工具。

Q一切技术咨询题都处理了,收录依然慢怎样办 A这时分要提升站点的全体权重。多建立高质量外链,添加社交信号,让搜索引擎以为你的站点是威望的,它自然会更频繁地来抓取。

Q用AI生成内容确实不妨碍收录吗 A关键看你怎样用。直截了当复制粘贴必定不可。但用它做内容拓展和初稿生成,你再参加专业数据和真实案例,效率高质量也好——搜索引擎要的是优质内容,不在乎是谁写的。